2020. 5. 7. 22:17ㆍAI/RL

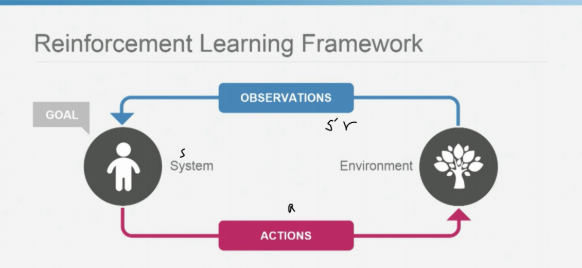

• 강화학습 :

- 지도학습 및 비지도학습과 더불어 기계학습의 3가지 기본적인 방법론 중 하나이다.

- 사람의 도파민 시스템과 비슷하며, 의사결정(MDP)을 최적화 하는 기술을 수학적으로 정의한 것이다.

- 주어진 불확실한 상황에서 상호작용으로부터 배우는 목표 지향적인 학습에 초점이 맞춰져 있다.

-

조건 :

- 행동의 결과는 최대 보상을 가져와야 함

- 행동은 시행착오를 통해 찾아냄 (경험에 의존) -

강화학습의 특징 :

- 시행착오와 지연된 보상

- DP, MDP 의 개념을 활용함 (불확실한 모든 문제를 분명히 고려하고 목표 지향적)

- 탐험(Exploration) : 미래에 더 좋은 행동을 선택하기 위해 과거에 하지 않았던 행동을 시도- 활용(Exploitation) : 과거의 효과적이었던 행동을 선호

※ idea : 확률문제에서 기대값을 높은 신뢰도로 추정하려면 행동을 여러번 시도해야 함.

※ 탐험과 활용은 Trade-off 의 관계에 있다.

• 강화학습의 구성 요소 : 4가지

- 정책 Policy : 특정 시점에 학습자가 취하는 행동을 정의. 정책→행동 결정 (일반적으로, 확률 base)

MDP에서 정책(Policy)= 분포 of Action (when 상황 given)

- 보상신호 reward signal : 강화학습이 즉각적으로 성취할 목표를 정의 (일반적으로, stochastic 함수)

- 가치함수 value function : 시작 시점부터 누적된 보상의 총량, 장기적 관점의 목표 (상태 State와 관련있음)

- 환경모델 environment model : 환경의 변화를 모사한다. 환경의 Dynamics(동역학)

모델→계획(planning)에 사용. 다음 상태와 보상을 예측

* 결정을 평가할 때 가장 많이 고려하는 것은 가치다. 장기적으로 최대한 많은 보상을 얻기 위해서이다.

** 계획 : 미래의 상황을 경험하기 전에 가능성만을 고려

*** model-based 방법 : 모델&계획 을 사용하는 RL

**** model-free 방법 : 시행착오로 모델을 학습하고, 그 모델을 사용

• 상태 State :

강화학습에서 정책과 가치의 입력, 동시에 모델의 입/출력이 됨

표기법 :

- 확률 변수 : 대문자 (eg. 상태, 행동, 보상 : , 가치함수 추정값 :

)

- 실현된 변수 값 : 소문자 (eg. 변수 값 : , 가치함수 :

)

• 상태 S_t 추정값의 갱신

| |

alpha : 시간 간격 파라미터. 학습속도에 영향을 준다. (시간차 학습의 일종)

V(S_t) : S_t의 추정값

식에 대한 내용은 뒤에서 자세히 다룬다.

• 강화학습의 초기역사 :

- 19세기 초 : 해밀턴, 쟈코비 이론

- 1950년대 후반 : 리처드 벨만의 최적제어. 벨만방정식, DP.

- Stochastic MDP

- 1960년대 : MDP의 Policy Iteration

'AI > RL' 카테고리의 다른 글

| [단단한 강화학습] #2 다중선택(Multi-armed Bandits) (2) | 2020.05.09 |

|---|---|

| [스터디파이] 강화학습 단기집중 과정 Course 참여 (1) | 2020.05.07 |